如何在大幅降低成本、保障数据隐私的前提下,训练出性能优越的AI模型?一项最新的研究给出答案。

10月23日,读特记者从香港理工大学人工智能高等研究院(PAAI)获悉,其研究团队在生成式人工智能(GenAI)领域取得多项关键技术突破。团队创新性地提出“协作式生成人工智能”模式,将AI训练从传统集中式转向分散式,能够降低训练成本、保障数据隐私,并打破数据资源壁垒,让更多研究机构得以参与AI研发。团队利用上述模式研发出“癌症GenAI”,正同步推进在复旦大学附属华山医院、中山大学肿瘤防治中心、山东省肿瘤医院等临床落地。

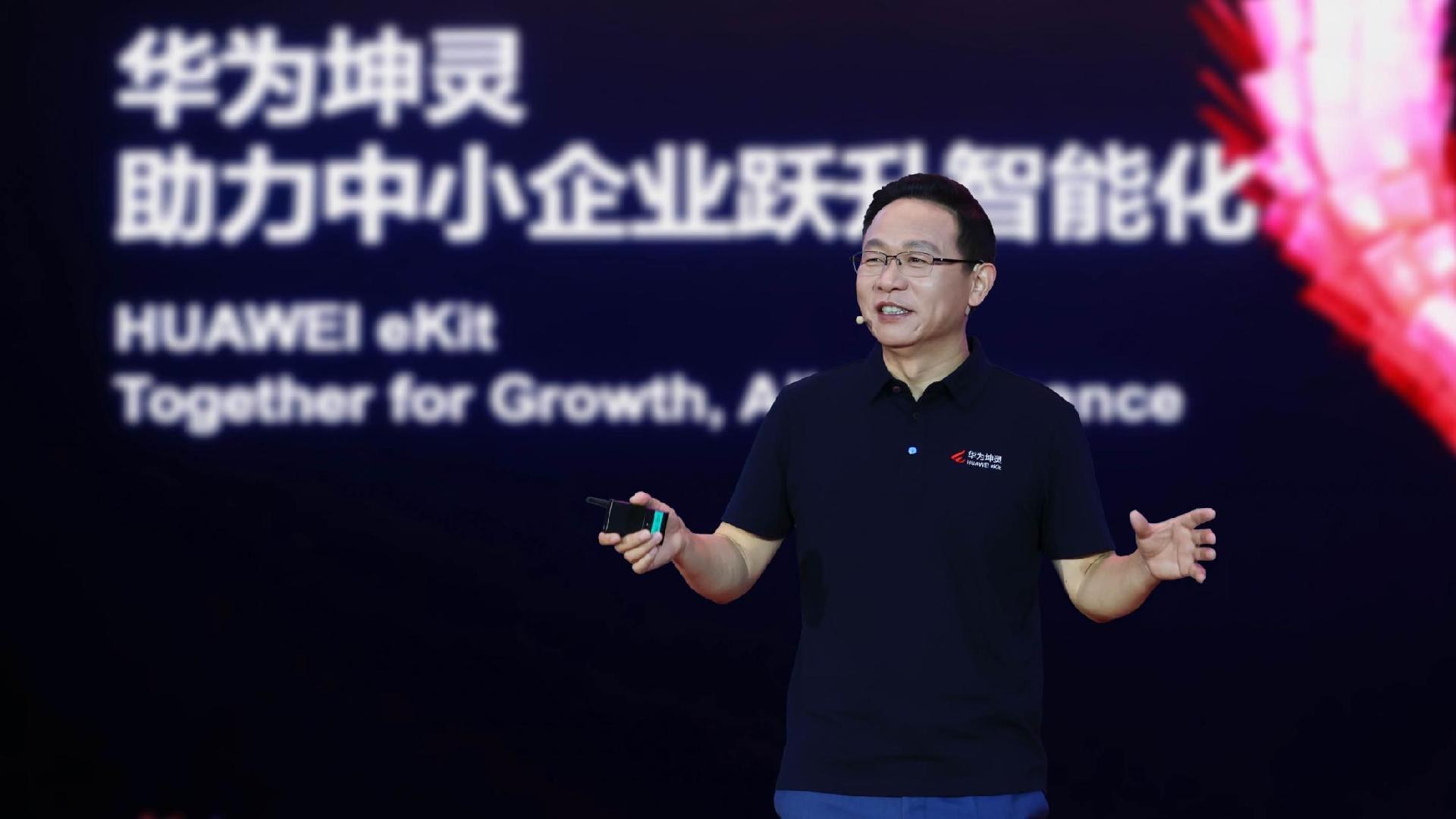

港理大PAAI执行院长、计算机及数学科学学院副院长(环球事务)、电子计算学系教授杨红霞指出,当前GenAI领域面临多方面挑战。一是基础模型训练需耗费巨量计算资源,仅少数机构能负担,因此学术界难以直接参与基础模型的训练,导致领域专属知识与数据无法融入模型。其次,数据的隐私保护与版权归属问题,使得医疗、金融等敏感数据难以用于训练。

基于上述痛点,港理工PAAI团队从低成本训练与分散式融合两个方向展开攻关,并在理论证明和应用落地方面取得突破性成果,打通了AI大模型落地的“最后一公里”。

在低成本训练方面,研究团队开源发布了一套名为“端到端FP8低比特训练”的全套解决方案,包含预训练及后训练。这一技术打破了当前全球基础模型以BF16精度训练的主流格局。一系列的数据体现出FP8的优势——训练速度提高20%以上,同时显存峰值占用减少逾一成,因此成本大幅下降。此外,FP8对“持续预训练”“监督式微调”“强化学习”进行整合,训练效果媲美BF16模型的同时,训练时间和显存占用也显著减少。

在分散式融合方面,团队也取得了重大突破。传统基础模型遵循“缩放定律”,即参数越多、知识越广、性能越强,采用集中式训练需要耗费数以百万计的GPU(图形处理器)小时。而港理工PAAI团队研发出“InfiFusion模型融合技术”,将人工智能训练从传统集中式转向分散式。研究结果表明,在InfiFusion模型融合技术下,数百GPU小时即可融合出传统基础模型需要100万至200万GPU小时训练的大模型。据悉,团队已启动训练成本比FP8更低的FP4相关研究。

“去中心化、分布式是未来生成式人工智能一个非常重要的趋势。”杨红霞认为,所有的技术突破一定是从中心化开始的,但如果想让技术广泛地应用于各行各业,一定是从分布式开始。

杨红霞直言,上述“小而美”的AI训练方法除了优点,的确也存在局限性。比如,领域小模型仅在特定领域表现优秀,相较于超大规模模型,其泛化性不足。她认为,未来的趋势应当是80-90%的问题由领域小模型解决,剩余的需要泛化的问题再交由中心化的通用大模型处理,从而平衡成本和实际效果。

记者了解到,目前港理工PAAI团队正在积极推动相关研究成果在医疗领域落地,并且已取得一系列进展。团队利用上述技术训练出性能领先的医疗基础大模型,并研发出专门在癌症领域应用的生成式AI大模型“癌症GenAI”。实验结果表明,这一模型在同规模模型中性能最佳,可快速积累高质量医疗数据、直接对接医疗设备,用于癌症个性化治疗规划。目前,团队正在联合复旦大学附属华山医院、中山大学肿瘤防治中心、山东省肿瘤医院及香港伊利沙伯医院落地临床。

港理大高级副校长(研究及创新)赵汝恒(左)与PAAI执行院长、计算机及数学科学学院副院长(环球事务)、电子计算学系教授杨红霞(右)出席新闻发布会。

港理大高级副校长(研究及创新)赵汝恒表示,人工智能是加速培育新质生产力的核心,理大新成立的PAAI致力加速人工智能技术在各个重点领域的深度融合,并针对不同行业开发具备专业领域知识的人工智能模型。

编辑 刘悦凌 审读 伊诺 二审 关越 三审 刘思敏