过去的一周,美国AI领域发展迅猛。

在OpenAI推出视频生成模型Sora,震惊世界之际,又一家硅谷初创企业、人工智能芯片公司Groq带着史上最快的大模型和自研芯片LPU霸占了热搜,一夜走红。

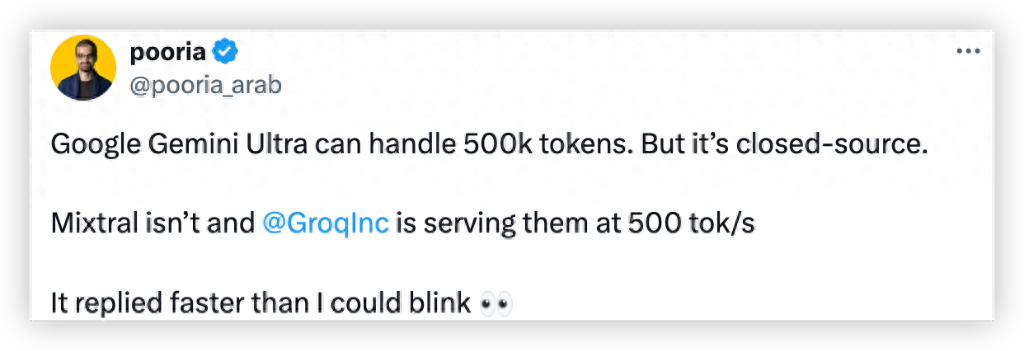

美东时间2月19日,AI芯片创企Groq开放了自家产品的免费试用。相比其他AI聊天机器人,Groq闪电般的响应速度迅速引爆互联网讨论。经过网友测试,Groq每秒生成速度接近500 tok/s,碾压GPT-4的40 tok/s。

有网友震惊地说:它回复的速度比我眨眼还快。

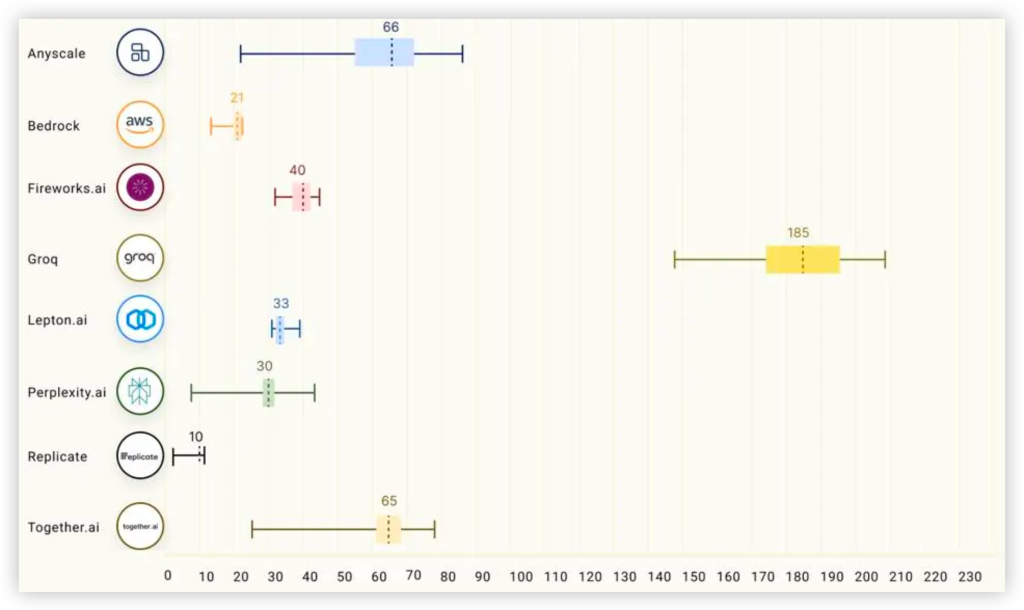

据外媒称,Groq闪电般快速的演示在周末疯传,使得当前版本的ChatGPT、Gemini甚至Grok看起来都很缓慢。Groq声称提供“世界上最快的大型语言模型”,第三方测试表明这一说法可能成立。

这是 Groq(Llama 2)和 ChatGPT 面对同一个提示文字的表现:

冠绝大模型圈子的响应速度,来自驱动模型的硬件——Groq并未使用英伟达的GPU,而是自研了新型AI芯片——LPU(Language Processing Units)。据介绍,Groq的大模型推理芯片是全球首个LPU(Language Processing Unit)方案,是一款基于全新的TSA 架构的Tensor Streaming Processor (TSP) 芯片,旨在提高机器学习和人工智能等计算密集型工作负载的性能。

LPU与GPU核心区别就是LPU内存采用了SRAM,而不是HBM。LPU采用了时序指令集计算机架构,这意味着它无需像使用高带宽存储器(HBM)的GPU那样频繁地从内存中加载数据。这一特点不仅有助于避免HBM短缺的问题,还能有效降低成本。

根据官方的数据显示,Groq的LPU芯片的性能表现相当出色,可以提供高达1000 TOPS (Tera Operations Per Second) 的计算能力,并且在某些机器学习模型上的性能表现可以比常规的GPU和TPU提升10到100倍。

由于ChatGPT-3.5主要是基于NVIDIA的GPU,也就是说,Groq LPU芯片的响应速度达到了NVIDIA GPU的10倍以上。Groq表示,相对于其他云平台厂商的大模型推理性能,基于其LPU芯片的云服务器的大模型推理性能最终实现了比其他云平台厂商快18倍。

图片来源:GIT HUB

Groq LPU搭配Meta Llama 2 70B能在7分钟内就能生成与莎士比亚《哈姆雷特》相同数量的单词,比普通人的打字速度快75倍。

有推特网友问了一个和营销有关的专业问题,Groq在四秒钟之内就输出了上千词的长篇大论。

在今天互联网上一炮而红之前,Groq已经低调埋头研发7年多的时间。

公开资料显示,Groq成立于2016年,总部位于美国加州圣塔克拉拉山景城。公司创始人Jonathan Ross是前谷歌高级工程师,是谷歌自研AI芯片TPU的设计者之一。产品主管John Barrus曾在谷歌及亚马逊担任产品高管。

高管内唯一一位华裔面孔、副总裁Estelle Hong,在公司任职已有四年,此前曾供职于美国军队及英特尔。

就在去年8月,Groq也宣布了和三星的合作计划,表示其下一代芯片将在美国得克萨斯州三星芯片工厂采用4纳米工艺生产,预计量产时间为2024年下半年。

展望下一代LPU,Ross相信GroqChip的能效将提高15到20倍,可以在相同的功率范围内为设备增加更多的矩阵计算和SRAM存储器。

确实快,但是贵,但业内专家普遍认为,目前Groq并不能成为英伟达的竞争对手。

因为,稍微算算账,就会发现,在它震撼的闪电速度背后,代价可能有点高。

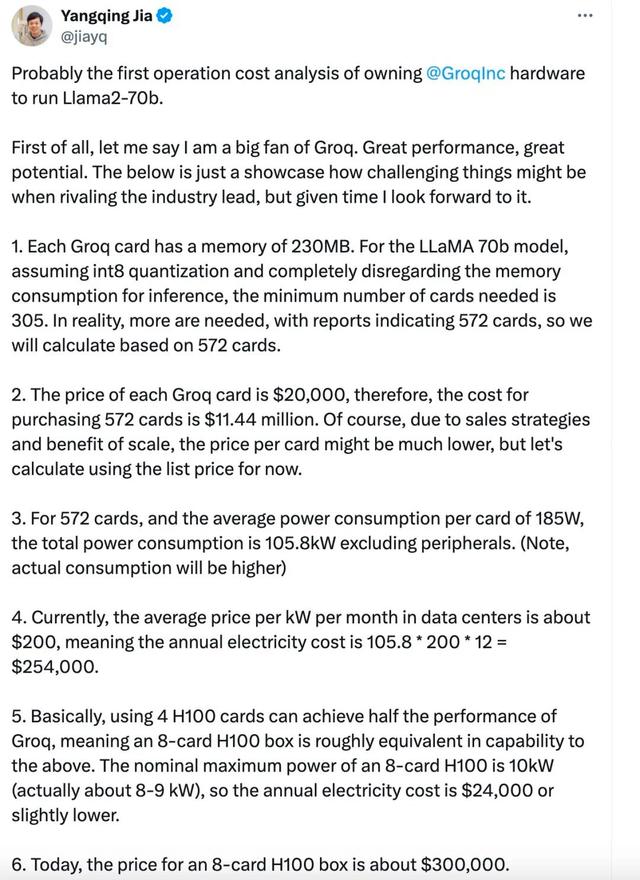

AI科学家、阿里巴巴技术副总裁贾扬清在推特上算了一笔账,因为Groq小得可怜的内存容量(230MB),在运行Llama-2 70b模型时,需要305张Groq卡才足够,而用H100则只需要8张卡。从目前的价格来看,这意味着在同等吞吐量下,Groq的硬件成本是H100的40倍,能耗成本是10倍。

尽管如此,Groq的技术和模式依然很有启发性。人工智能已经在科技界掀起了一场风暴。2023 年可能是世界意识到人工智能将成为现实的一年,而 2024 年则是人工智能真正成为现实而不仅仅是假设的一年。这是 Jonathan Ross 曾经表达的一个观点。

当我们拥有 100 万 Token 上下文的 Gemini Pro 1.5、每秒 500 Token 推理速度的 Groq、推理能力更进一步的 GPT-5,梦想还会远吗?

(综合来源:金融界 芯智讯 华尔街见闻 机器之心 腾讯科技 )

编辑 周梦璇 审读 张蕾 二审 李怡天 三审 刘思敏