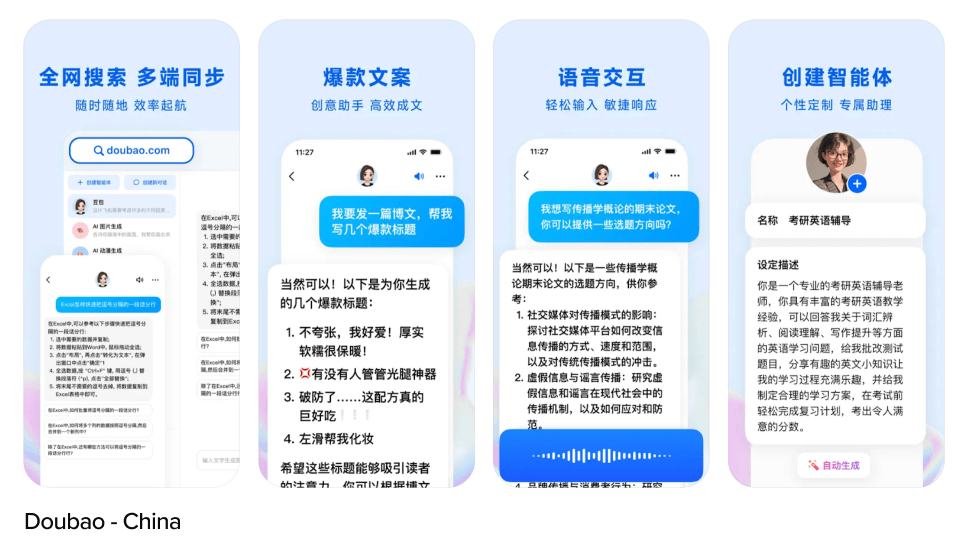

字节跳动正式宣告进军AI视频生成领域。9月24日,字节跳动旗下火山引擎在深圳举办AI创新巡展,一举发布了豆包视频生成-PixelDance、豆包视频生成-Seaweed两款大模型,面向企业市场开启邀测。

活动现场,火山引擎从语义理解能力、多个主体运动的复杂交互画面和多镜头切换的内容一致性等方面,展示了豆包大模型生成的视频效果。火山引擎总裁谭待表示,“视频生成有很多难关亟待突破。豆包两款模型会持续演进,在解决关键问题上探索更多可能性,加速拓展AI视频的创作空间和应用落地。”

火山引擎总裁谭待发布豆包视频生成模型。

豆包大模型已开放小范围测试

记者了解到,豆包视频生成模型的亮点之一是能实现自然连贯的多拍动作与多主体复杂交互。不同于此前视频生成模型大多只能完成简单指令,有创作者在抢鲜体验豆包大模型时发现,其生成的视频不仅能够遵循复杂指令,让不同人物完成多个动作指令的互动,人物样貌、服装细节甚至头饰,在不同运镜下也保持一致,接近实拍效果。

据火山引擎介绍,豆包视频生成模型基于DiT架构,通过高效的DiT融合计算单元,让视频在大动态与运镜中自由切换,拥有变焦、环绕、平摇、缩放、目标跟随等多镜头语言能力。全新设计的扩散模型训练方法更是攻克了多镜头切换的一致性难题,在镜头切换时可同时保持主体、风格、氛围的一致性。

相关负责人表示,经过剪映、即梦AI等业务场景打磨和持续迭代,豆包视频生成模型具备专业级光影布局和色彩调和,画面视觉极具美感和真实感。深度优化的Transformer结构,则大幅提升了豆包视频生成的泛化能力,支持3D动画、2D动画、国画、黑白、厚涂等多种风格,适配电影、电视、电脑、手机等各种设备的比例,不仅适用于电商营销、动画教育、城市文旅、微剧本等企业场景,也能为专业创作者和艺术家们提供创作辅助。

目前,新款豆包视频生成模型正在即梦AI内测版小范围测试,未来将逐步开放给所有用户。剪映和即梦AI市场负责人陈欣然认为,AI能够和创作者深度互动,共同创作,带来很多惊喜和启发,即梦AI希望成为用户最亲密和有智慧的创作伙伴。

定价低于行业99%

此次活动中,豆包大模型不仅新增视频生成模型,还发布了豆包音乐模型和同声传译模型,已全面覆盖语言、语音、图像、视频等全模态,全方位满足不同行业和领域的业务场景需求。

在产品能力日益完善的同时,豆包大模型的使用量也在急速增长。据火山引擎披露,截至9月,豆包语言模型的日均tokens使用量超过1.3万亿,相比5月首次发布时猛增十倍,多模态数据处理量也分别达到每天5000万张图片和85万小时语音。

此前,豆包大模型公布了低于行业99%的定价。谭待认为,大模型价格已不再是阻碍创新的门槛,随着企业大规模应用,大模型支持更大的并发流量正在成为行业发展的关键因素。

据谭待介绍,业内多家大模型目前最高仅支持300K甚至100K的TPM(每分钟token数),难以承载企业生产环境流量。例如某科研机构的文献翻译场景,TPM峰值为360K,某汽车智能座舱的TPM峰值为420K,某AI教育公司的TPM峰值更是达到630K。为此,豆包大模型默认支持800K的初始TPM,远超行业平均水平,客户还可根据需求灵活扩容。

“在我们努力下,大模型的应用成本已经得到很好解决。大模型要从卷价格走向卷性能,卷更好的模型能力和服务。”谭待表示。

(图片来自字节跳动)

编辑 许家宜 审读 伊诺 二审 李怡天 三审 刘思敏