读特融媒体记者从鹏城实验室获悉,近日,鹏城实验室网络智能研究部视觉智能研究所与中国科学院、华为公司共同合作,分别在Github和OpenI启智社区开源了高效高精度视觉表征模型—视觉状态空间模型VMamba,为解决视觉识别的核心问题开辟了新途径。

记者了解到,VMamba把选择性状态空间模型Mamba的潜力拓展到视觉领域。Mamba是2023年12月卡内基梅隆大学与普林斯顿大学合作提出的一种全新的基础模型架构。Mamba在语言建模方面可以媲美甚至击败大模型Transformer,一经发布,即引起了人工智能领域的轰动。

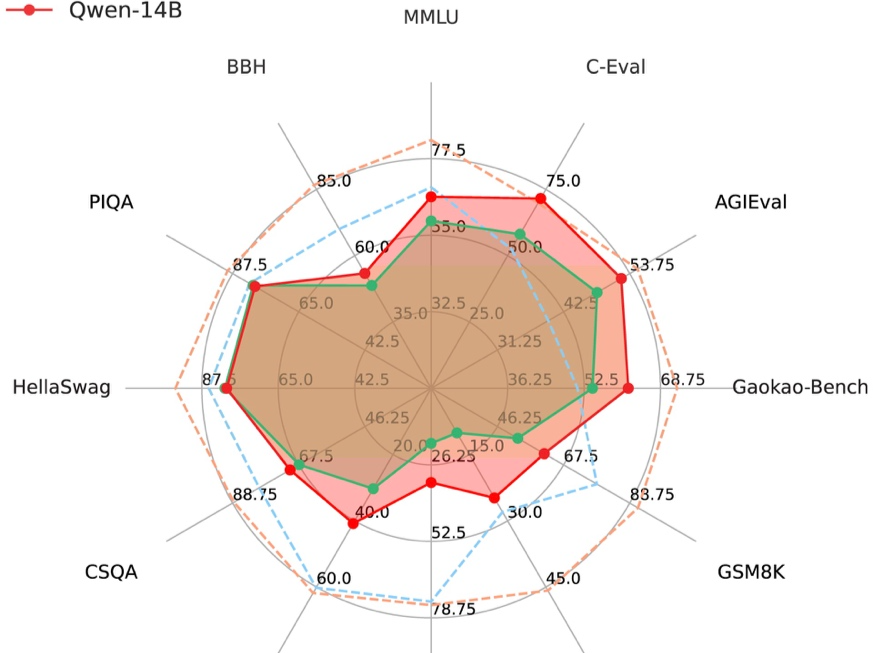

据悉,VMamba模型采用一种独特的交叉扫描(Cross-Scan)机制,首次在Mamba加速模型框架下实现了多尺度特征的高效提取,模型性能以显著优势超越了现有主流模型。在标准数据集上,尤其在ImageNet-1K数据集的分类任务中,VMamba模型的准确率达到83.5%。在COCO数据集的目标检测任务和ADE20K数据集的语义分割任务上,VMamba同样以显著优势超越了现有主流模型。

目前,VMamba模型的创新性与卓越性能得到学术界认可,相关论文被国际著名AI开源社区Huggingface选作为Daily Papers进行展示。

VMamba相关论文入选Huggingface Daily Papers。

编辑 高原 审读 郭建华 二审 郑蔚珩 三审 刘思敏