“芯片问题其实没必要担心”“我们用数学补物理、非摩尔补摩尔,用群计算补单芯片,在结果上也能达到实用状况。”

这是华为首席执行官任正非今年接受人民日报采访时关于芯片的一段表述,其中“用群计算补单芯片”的技术突破指的就是昇腾384超节点。

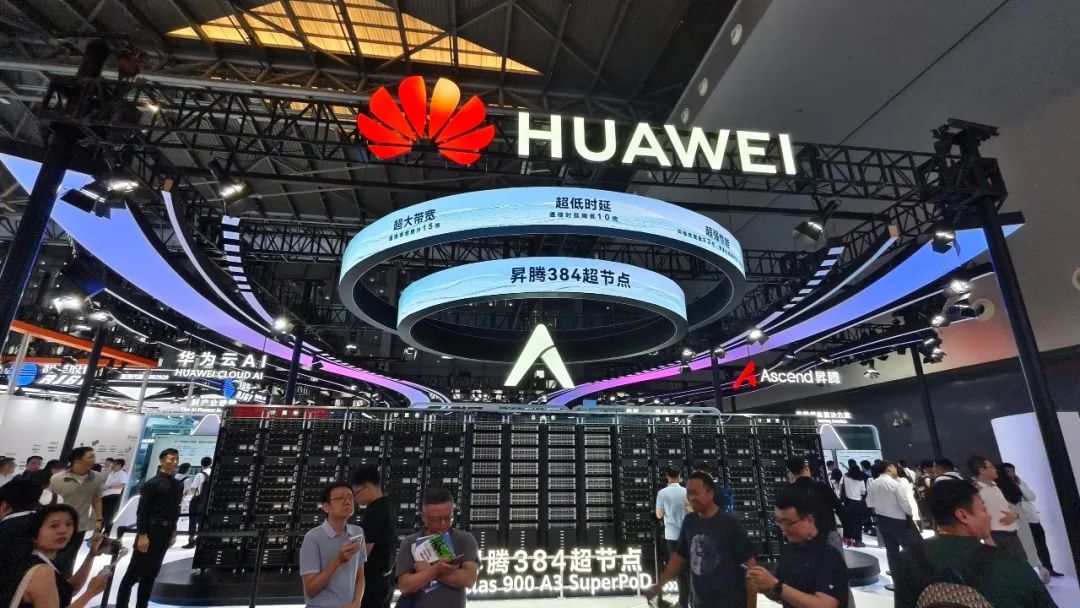

图源:IC photo。

2025世界人工智能大会(WAIC)展馆内,华为昇腾展区又成功出圈。这是华为在5月鲲鹏昇腾开发者大会发布昇腾384超节点技术后,首次以实体形式向全球展示其全栈AI能力。

作为首次线下亮相,华为这套超节点硬是把384颗升腾NPU以及192颗鲲鹏CPU拧成一股绳,通过MatrixLink高速网络连接起来,变成一台完整的超级服务器。这一台“算力核弹”,单卡每秒能处理的数据量,简单说就是AI读文字出答案的速度,将比传统设备快非常多。

据官方公告,华为的AI算力集群解决方案CloudMatrix 384,基于384颗昇腾芯片构建,通过全互连拓扑架构实现芯片间高效协同,在算力规模、内存容量和带宽等方面显著领先英伟达NVL72。

总算力高达300 PFLOPs的密集BF16算力,接近英伟达GB200 NVL72系统的两倍(英伟达NVL72约180 PFlops),网络互联总带宽达269TB/s(英伟达NVL72约130TB/s),内存容量和带宽分别是英伟达方案的3.6倍和2.1倍。尽管单颗昇腾芯片性能约为英伟达Blackwell架构GPU的三分之一,但华为通过超节点架构和系统工程优化,实现了整体算力的显著跃升,并在超大规模模型训练、实时推理等场景中展现出更强的竞争力。

按照国外投行的说法,华为的规模化解决方案“领先于英伟达和AMD目前市场上的产品一代”,并认为中国在AI基础设施上的突破将对全球AI产业格局产生深远影响。

这一技术突破,让黄仁勋的那句“华为芯片在AI训练中替代英伟达只是时间问题”的含金量又上升了,标志着国产AI算力真正进入国际竞争深水区。

当前,大模型训练经历了从早期小模型在单卡训练、小参数大模型在单机训练,到现在MoE、长序列、多模态大模型都在AI集群上训练的演进过程。AI算力的瓶颈,从单卡算力的瓶颈到单机内总线带宽的瓶颈,再到现在集群间通信带宽的瓶颈,需求增长了1万倍。

然而过去的8年里,单卡硬件的算力增长了40倍,但是节点内的总线带宽只增长了9倍,跨节点的网络带宽只增长了4倍,这使得集群网络通信成为当前大模型训练和推理的最大挑战。

昇腾384超节点这项技术创新跳出单点技术限制走向系统性、工程性的创新算力架构,直面通信效率瓶颈、内存墙制约、可靠性短板三大技术挑战。

昇腾384超节点的亮相,标志着中国算力从追赶转向并跑甚至领跑。华为通过系统级创新绕开了单芯片工艺的限制,为国产AI产业开辟了一条独特的发展路径。

这一突破的产业价值正在释放。随着昇腾超节点技术突破,国产AI算力已从‘可用’向‘好用’演进,具备昇腾认证资质的系统集成商将获得新的发展空间。

但挑战犹存。如何将技术领先转化为持续的生态优势?华为的答案是:开源开放。华为全方位展示其开源开放的软硬件生态,包括CANN、MindSpore等开发工具链。

这种开放策略正吸引更多开发者加入昇腾生态。目前业界已基于昇腾适配和开发超过80个大模型,在基础大模型方面多个技术方向均有积累,如讯飞星火认知、DeepSeek、Qwen、鹏城、LLaMA等。同时,昇腾联合2700+行业合作伙伴,共同孵化了超过6000+个行业解决方案,使能百模千态,加速行业智能化。

“这不是一台超级计算机,而是一份技术主权宣言。”未来十年,全球AI竞赛的胜负手,或将由此改写。

来源:察理思特

记者:叶梅